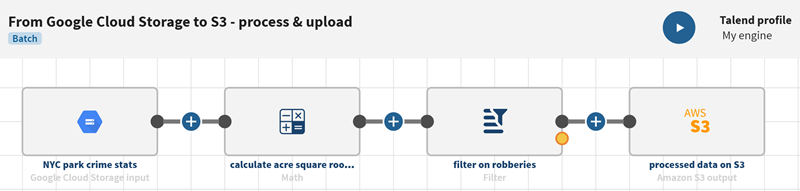

Traiter des statistiques stockées dans Google Cloud Storage et charger les données dans Amazon S3

Ce scénario a pour objectif de vous aider à configurer et à utiliser des connecteurs dans un pipeline. Ce scénario doit être adapté en fonction de votre environnement et de votre cas d'utilisation.

Avant de commencer

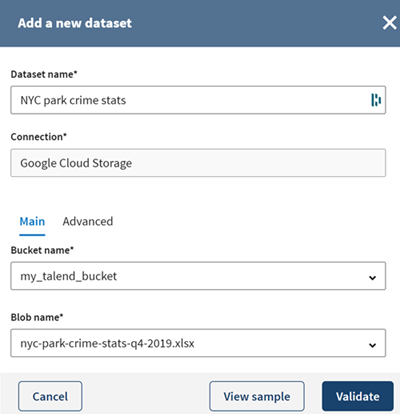

- Si vous souhaitez reproduire ce scénario, téléchargez le fichier gcstorage_s3_nyc_stats.xlsx. Ce fichier est un extrait du jeu de données libre d'accès nyc-park-crime-stats-q4-2019.xlsx de New York City.

Procédure

Résultats

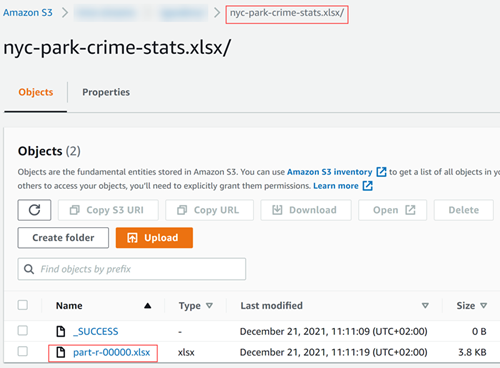

Votre pipeline est en cours d'exécution et le flux de sortie est envoyé au bucket Amazon S3 indiqué.

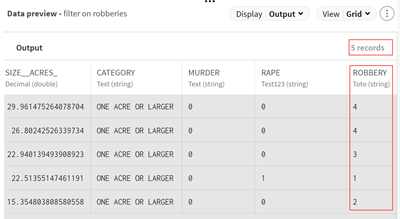

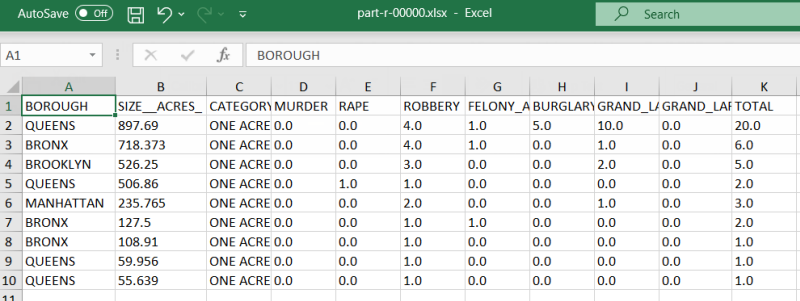

Si vous avez téléchargé le fichier de sortie, vous pouvez voir que les données des crimes ont été traitées et que les cas de vols ont été isolés.

Cette page vous a-t-elle aidé ?

Si vous rencontrez des problèmes sur cette page ou dans son contenu – une faute de frappe, une étape manquante ou une erreur technique – dites-nous comment nous améliorer !