DBFSからジョブにデータをロードするようにtFileInputDelimitedコンポーネントを設定します。

手順

-

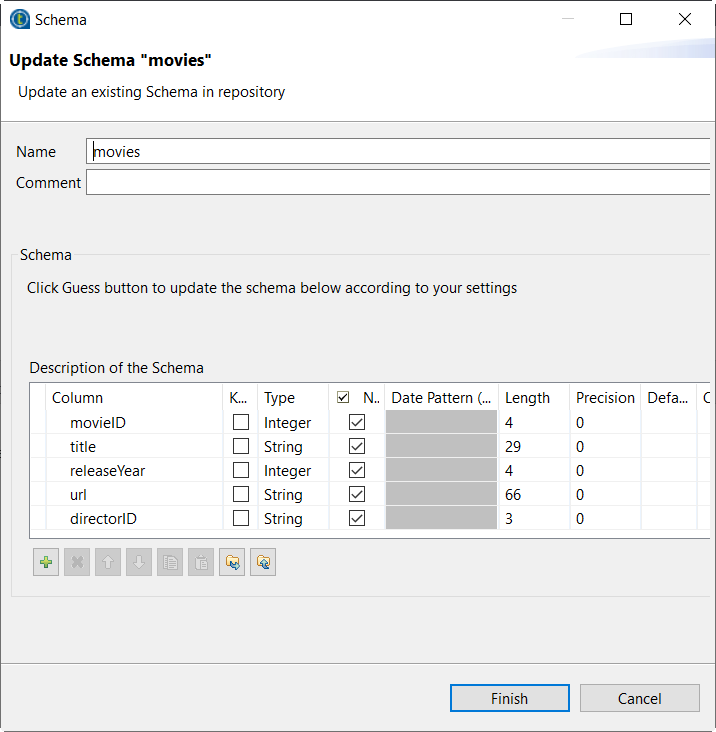

[Repository] (リポジトリー)の[Metadata] (メタデータ)ノードの下で、[File delimited] (ファイル区切り)ノードに続いてmoviesファイル接続ノードとその子ノードを展開して、moviesスキーマメタデータノードを表示します。

-

このスキーマメタデータノードをダブルクリックして、ウィザードを開きます。

-

ボタンをクリックして、スキーマをローカルディレクトリーにエクスポートします。

ボタンをクリックして、スキーマをローカルディレクトリーにエクスポートします。

-

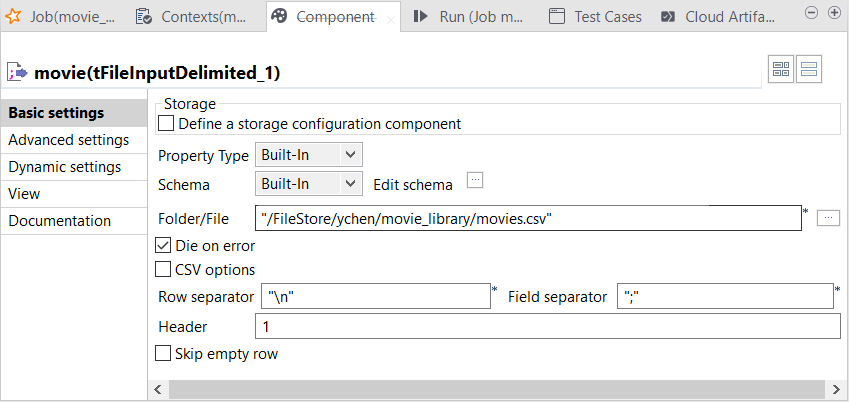

movie tFileInputDelimitedコンポーネントをダブルクリックして[Component] (コンポーネント)ビューを開きます。

-

[Define a storage configuration component] (ストレージ設定コンポーネントを定義)チェックボックスがクリアされていることを確認します。これにより、このコンポーネントは、Sparkクラスターのファイルシステムからデータを直接読み取り、後で[Spark configuration] (Spark設定)タブで定義できます。 このシナリオでは、このファイルシステムはDBFSです。

-

[Edit schema] (スキーマを編集)をクリックしてスキーマのエディターを開き、

ボタンをクリックして、以前に[Repository] (リポジトリー)の[File delimited] (ファイル区切り)メタデータからエクスポートした映画データのスキーマをインポートします。

ボタンをクリックして、以前に[Repository] (リポジトリー)の[File delimited] (ファイル区切り)メタデータからエクスポートした映画データのスキーマをインポートします。

-

[Folder/File] (フォルダー/ファイル)フィールドで、DBFSに保存されている映画データを指すパスを入力します。

-

[Header] (ヘッダー)フィールドで、引用符をつけずに1と入力します。これにより、コンポーネントはデータの最初の行をデータヘッダーとして認識できます。

-

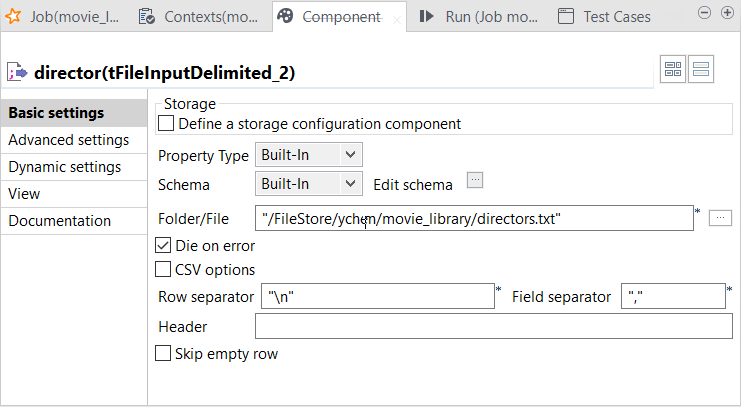

director tFileInputDelimitedコンポーネントをダブルクリックし、その[Component] (コンポーネント)ビューを開きます。

-

前の手順で説明したのと同じ理由で、[Define a storage configuration component] (ストレージ設定コンポーネントを定義)チェックボックスがクリアされていることを確認します。

-

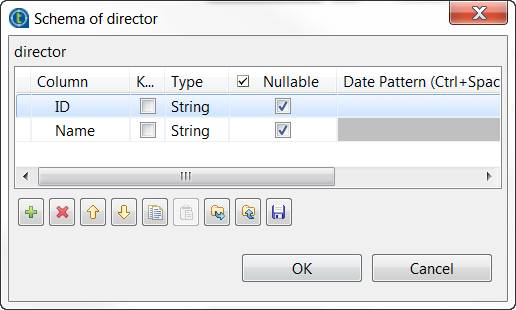

[Edit schema] (スキーマを編集)の横の[...]ボタンをクリックし、スキーマエディターを開きます。

-

[+]ボタンを2回クリックして2つの行を追加し、[Column] (カラム)カラムで名前をそれぞれIDとNameに変更します。

-

[OK]をクリックしてこれらの変更を確認し、ポップアップ表示されるダイアログボックスで求められるプロパゲーションを承認します。

-

[Folder/File] (フォルダー/ファイル)フィールドで、ディレクターデータが保存されているディレクトリーを入力します。DBFS(Databricks File System)にファイルをアップロード (英語のみ)で説明しているように、このデータは/FileStore/ychen/movie_library/directors.txtに書き込まれています。

-

[Field separator] (フィールド区切り)フィールドにコンマ(,)を入力します。ディレクターデータではこれが区切り文字として使用されているためです。

タスクの結果

これで、映画データとディレクターデータをジョブにロードするように入力コンポーネントが設定されました。

ボタンをクリックして、スキーマをローカルディレクトリーにエクスポートします。

ボタンをクリックして、スキーマをローカルディレクトリーにエクスポートします。

ボタンをクリックして、以前に

ボタンをクリックして、以前に