Atlasを使ってデータ来歴を設定

Apache Atlasに対するサポートがTalend Sparkジョブに追加されました。

ジョブの実行にHortonworks Data Platform V2.4以降を使用しており、HortonworksクラスターにApache Atlasがインストールされている場合は、Atlasを利用して特定のデータフローの来歴をトレースし、このジョブに使用されているコンポーネントおよびコンポーネント間のスキーマの変更を含め、このデータがSparkジョブによってどう生成されたかを確認できます。ClouderaクラスターにApache Atlasがインストールされており、CDP Private Cloud BaseまたはCDP Public Cloudを使って自分のジョブを実行している場合は、ジョブの実行でAtlasを使うこともできます。

CDPダイナミックディストリビューションを使用している場合は、Talendが提供する8.0.1 R2023-06以降のTalend Studioマンスリーリリースをインストールすると、[Use Atlas] (Atlasを使用)チェックボックスが[Use Cloudera Navigator] (Cloudera Navigatorを使用)チェックボックスに置き換えられます。

- Hortonworks Data Platform V2.4の場合、Talend StudioによるサポートはAtlas 0.5のみになります。

- Hortonworks Data Platform V2.5の場合、Talend StudioによるサポートはAtlas 0.7のみになります。

- Hortonworks Data Platform V3.14の場合、Talend StudioによるサポートはAtlas 1.1のみになります。

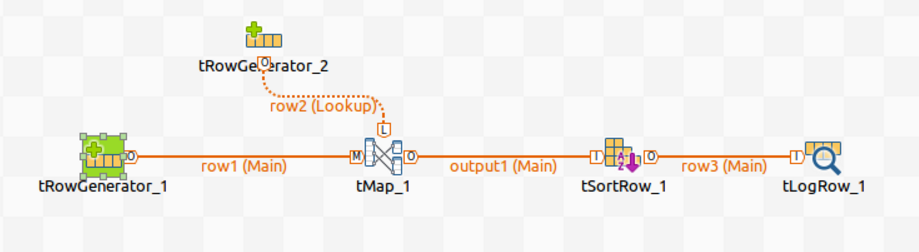

たとえば以下のSpark Batchジョブをデザインし、そこでAtlas内にそれに関する来歴情報を生成するとします。

このジョブでは、入力データの生成にtRowGeneratorを使用し、データ処理にtMapとtSortRowを使用し、データを別の形式に出力するのに他のコンポーネントを使用します。

手順

タスクの結果

この時点までに、Atlasへの接続がセットアップ済みとなっています。このジョブを実行する時は、Atlas内に来歴が自動的に生成されています。

ジョブを正しく実行するには、[Spark configuration] (Spark設定)タブでさらにその他のパラメーターを設定する必要があります。詳細は、Spark Batchジョブを作成をご覧ください。

ジョブの実行が完了したら、このジョブによって書かれた来歴情報をAtlasで検索し、そこで来歴を読みます。

このページは役に立ちましたか?

このページまたはコンテンツに、タイポ、ステップの省略、技術的エラーなどの問題が見つかった場合は、お知らせください。改善に役立たせていただきます。