Neuheiten in R2022-04

Big Data: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

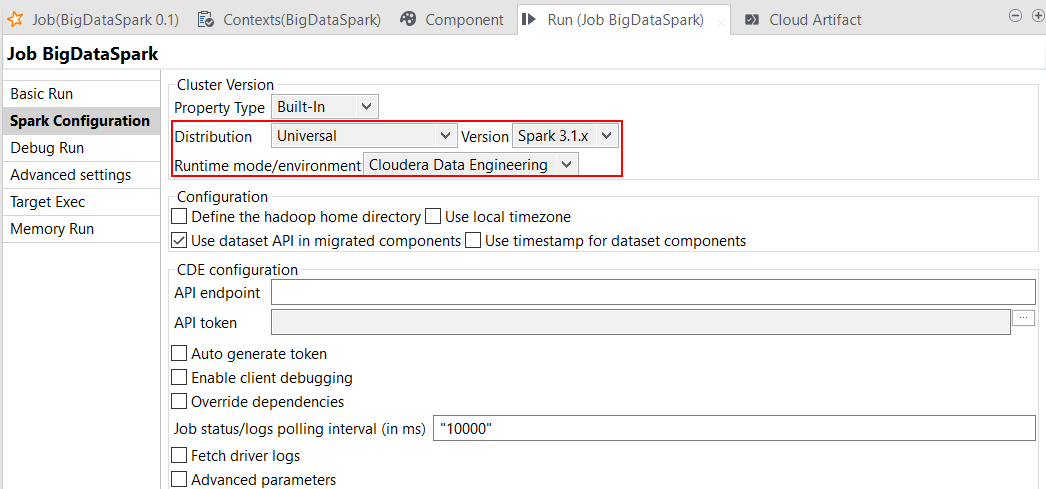

| Unterstützung für die Cloudera Data Engineer Experience mit AWS und Spark Universal 3.1.x | Sie können Ihre Spark-Jobs jetzt mit einer Cloudera Data Engineer Experience unter Rückgriff auf Spark Universal mit Spark 3.1.x ausführen. Die entsprechende Konfiguration können Sie in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs vornehmen.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

| Unterstützung für Databricks Runtime 8.x bis 9.x mit Job-Clustern unter Verwendung von Spark Universal 3.1.x | Sie können Ihre Spark-Jobs jetzt in einem Databricks-Job-Cluster unter Rückgriff auf Spark Universal mit Spark 3.1.x ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, ist Studio Talend mit den Databricks-Versionen 8.x bis 9.x kompatibel. |

Alle abonnementbasierte Produkte von Talend mit Big Data |

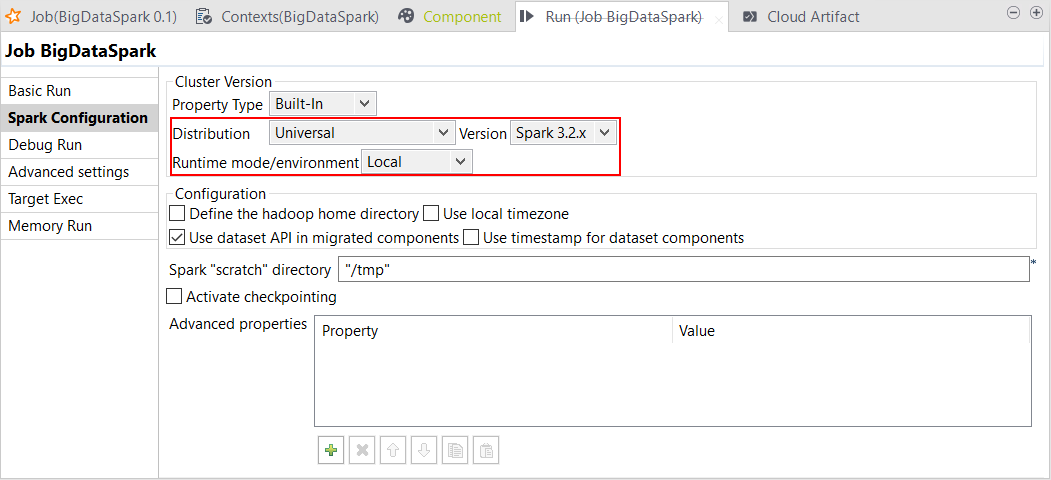

| Unterstützung für Spark Universal 3.2.x im lokalen Modus | Sie können Ihre Spark-Jobs jetzt unter Rückgriff auf Spark Universal mit Spark 3.2.x im lokalen Modus (Local) ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, generiert Studio Talend zur Laufzeit intern die Spark-Umgebung, damit der Job lokal innerhalb von Studio Talend ausgeführt werden kann. Big Data-Komponenten von Talend Data Mapper (tHConvertFile, tHMapFile, tHMapInput und tHMapRecord) sind im Augenblick nicht kompatibel mit Spark 3.2.x. Da es sich nur um eine Betafunktion handelt, ist dies nicht für die Produktionsumgebung geeignet.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

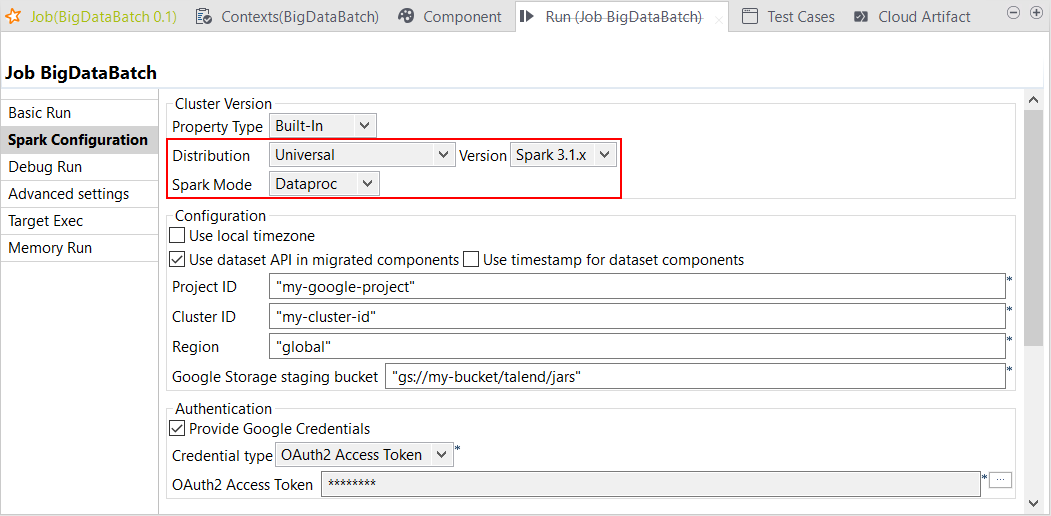

| Unterstützung für Google Dataproc 2.0.x mit Spark Universal 3.1.x | Sie können Ihre Spark-Jobs jetzt in einem Google Dataproc-Cluster unter Rückgriff auf Spark Universal mit Spark 3.1.x ausführen. Die entsprechende Konfiguration können Sie in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs vornehmen. Wenn Sie diesen Modus auswählen, ist Studio Talend mit der Version Dataproc 2.0.x nur für Spark Batch- und Spark Streaming-Jobs kompatibel. Standard-Jobs mit Hive-Komponenten werden im Augenblick nicht unterstützt.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

| Unterstützung für mehrere tGSConfiguration-Komponenten in Spark-Jobs | Sie können jetzt mehrere tGSConfiguration-Komponenten in einem Job einsetzen, um verschiedene Google Storage-Buckets mit unterschiedlichen Anmeldedaten verwenden zu können. Diese Funktion gilt sowohl für Spark Batch- als auch für Spark Streaming-Jobs. |

Alle abonnementbasierte Produkte von Talend mit Big Data |

| Unterstützung für CDP Public Cloud mit Knox und Impala für Standard-Jobs | Wenn Sie CDP Public Cloud zur Ausführung Ihrer Standard-Jobs verwenden, können Sie jetzt sowohl Knox als auch Impala nutzen. |

Alle abonnementbasierte Produkte von Talend mit Big Data |

| Unterstützung für die AWS EMR-Distributionen 6.3.x, 6.4.x und 6.5.x mit Spark Universal 3.1.x | Sie können Ihre Spark-Jobs jetzt in einem AWS EMR-Cluster unter Rückgriff auf Spark Universal mit Spark 3.1.x im Yarn-Cluster-Modus ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, ist Studio Talend mit den AWS EMR-Versionen 6.3.x, 6.4.x und 6.5.x kompatibel. Spark-Jobs funktionieren im Augenblick nicht mit der tHiveConnection-Komponente. |

Alle abonnementbasierte Produkte von Talend mit Big Data |

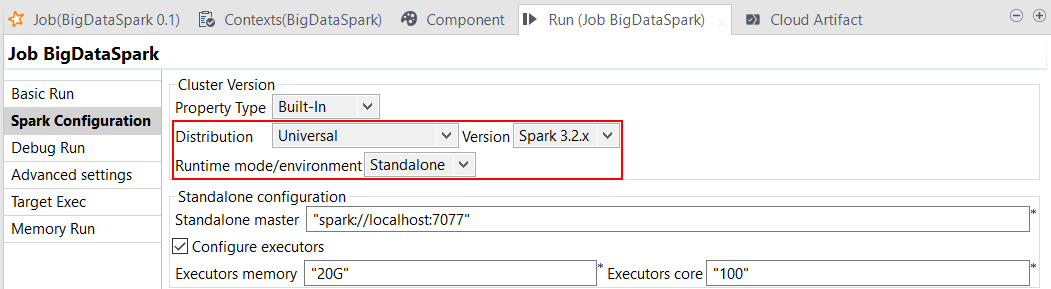

| Unterstützung für Open Source Apache Spark Standalone-Cluster mit Spark Universal 3.2.x | Sie können Ihre Spark-Jobs jetzt unter Rückgriff auf Spark Universal 3.2.x im Standalone-Modus ausführen. Die entsprechende Konfiguration können Sie in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs vornehmen. Bei der Auswahl dieses Modus stellt Studio Talend eine Verbindung zu einem Spark-fähigen Cluster für die Ausführung des Jobs ausgehend von diesem Cluster her.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

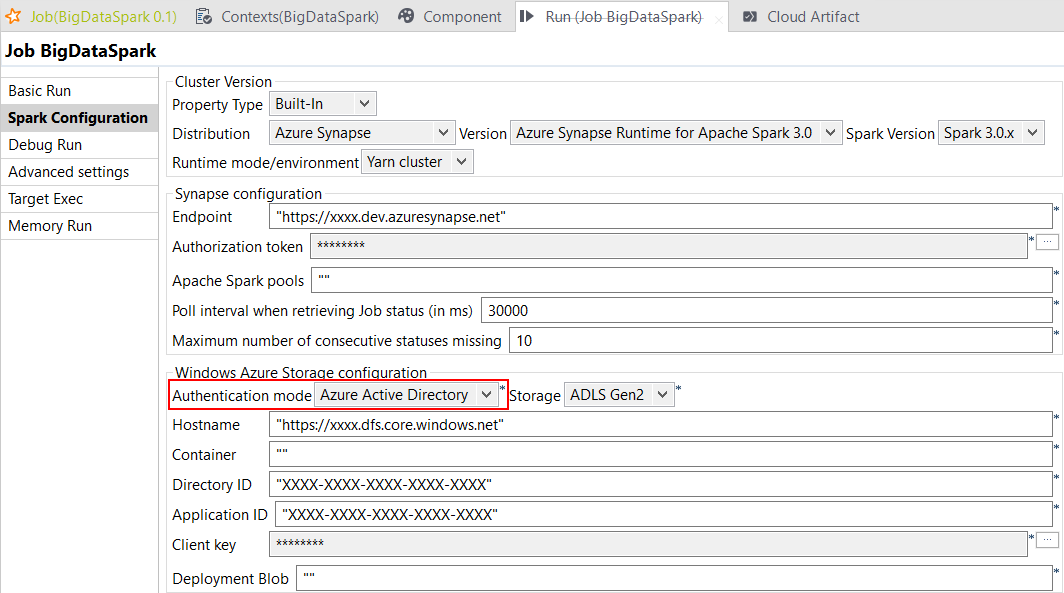

| Unterstützung für Azure Active Directory (AD) Service Principal für Azure Synapse Spark-Pools in Spark-Jobs |

Wenn Sie Azure Synapse Analytics mit Apache Spark-Pools als Distribution für Ihre Spark Batch- und Spark Streaming-Jobs verwenden, können Sie sich jetzt mit Azure AD Service Principal authentifizieren. Die entsprechende Konfiguration können Sie in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs vornehmen. Da es sich nur um eine Betafunktion handelt, ist dies nicht für die Produktionsumgebung geeignet.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

Data Integration: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

|

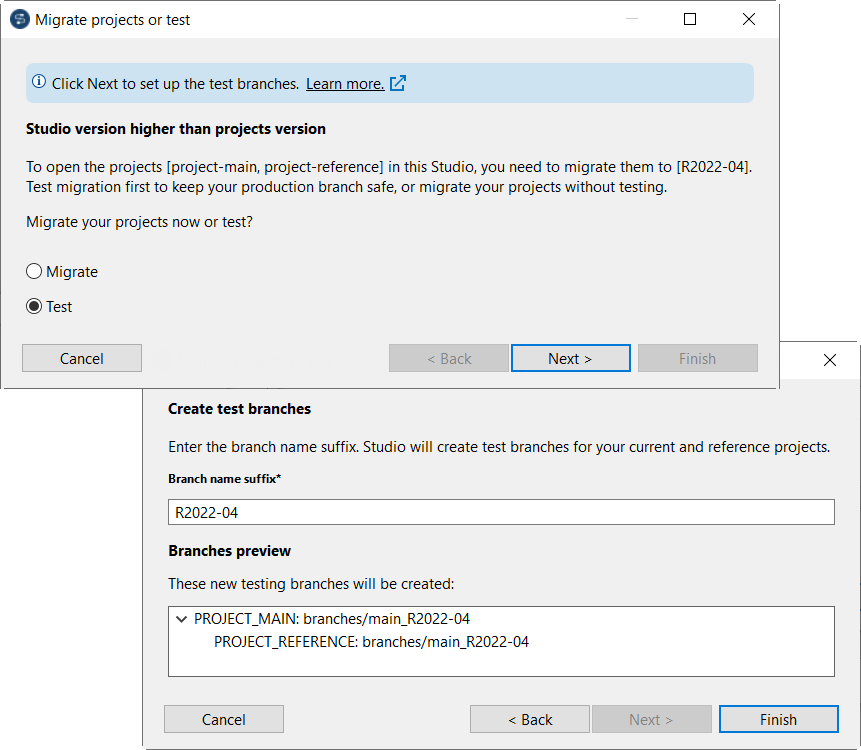

Studio Talend kann jetzt automatisch Test-Branches für den Test der Migration von dezentralen Projekten erstellen. |

Studio Talend stellt jetzt den neuen Assistenten Migrate projects or test (Projekte migrieren oder testen) mit den folgenden zwei Optionen bereit:

Der Assistent wird angezeigt, sobald Sie ein dezentrales Projekt öffnen, dessen Version kleiner ist als die Studio Talend-Version.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

|

Neue Komponente für das Schreiben von Daten in ein aktives ADSO über den SAP Java-Konnektor Version 3 |

Diese Release umfasst die Komponente tSAPADSOOutput, die Ihnen das Schreiben von Daten in ein aktives Advanced Data Store Object (ADSO) über den SAP Java-Konnektor Version 3 ermöglicht. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

|

Neue Komponenten zum Auflisten und Löschen von Dateien auf einem Samba-Host |

Diese Release stellt die folgenden neuen Komponenten bereit:

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

|

Unterstützung für den Microsoft SQL-Server Version 2019 |

Diese Release bietet Unterstützung für den Microsoft SQL-Server Version 2019, die beim Aufbau einer Verbindung zu einem Microsoft SQL-Server eine Azure Active Directory-Authentifizierung ermöglicht. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

|

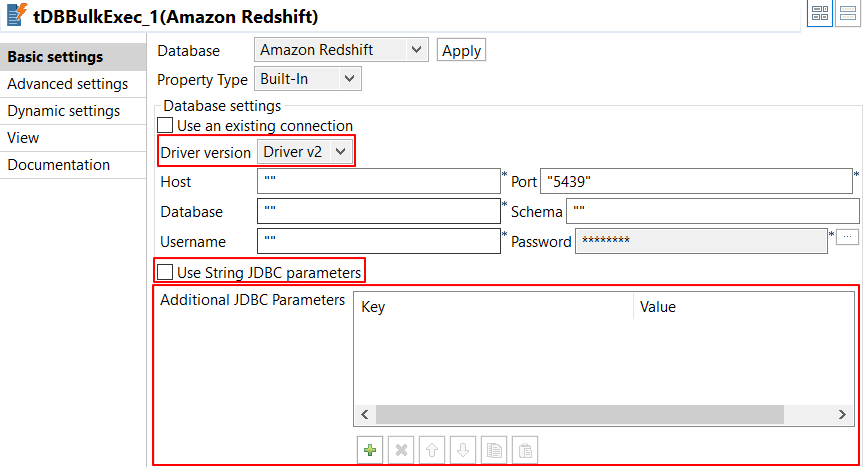

Unterstützung für den Redshift-Treiber v2.x |

Diese Release bietet Unterstützung für den Redshift-Treiber v2.x. Für die folgenden Redshift-Komponenten wurde die Option Driver version (Treiberversion) hinzugefügt: tRedshiftInput, tRedshiftUnload, tRedshiftOutput, tRedshiftConnection, tRedshiftRow, tRedshiftOutputBulkExec, tRedshiftBulkExec. Die Vorgehensweise zur Angabe der JDBC-Parameter fällt je nach Treiber v1 und Treiber v2 unterschiedlich aus. Detaillierte Informationen finden Sie unter „Standardeigenschaften von tRedshiftConnection“.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

| Unterstützung für ein dynamisches Schema für tSAPTableInput | Die Funktion „Dynamic Schema“ (Dynamisches Schema) wird jetzt für tSAPTableInput in Ihren Standard-Jobs mit der Verwendung von tSetDynamicSchema unterstützt. Mit dieser Funktion können Sie ein Schema auf nicht-statische Weise konfigurieren, d. h. Sie müssen Ihren Job bei einer künftigen Schema-Änderung nicht umschreiben und stellen dabei sicher, dass er stets ordnungsgemäß funktioniert. Sie können jetzt Tabellen, Spalten und Joins dynamisch bereitstellen. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

Data Quality: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

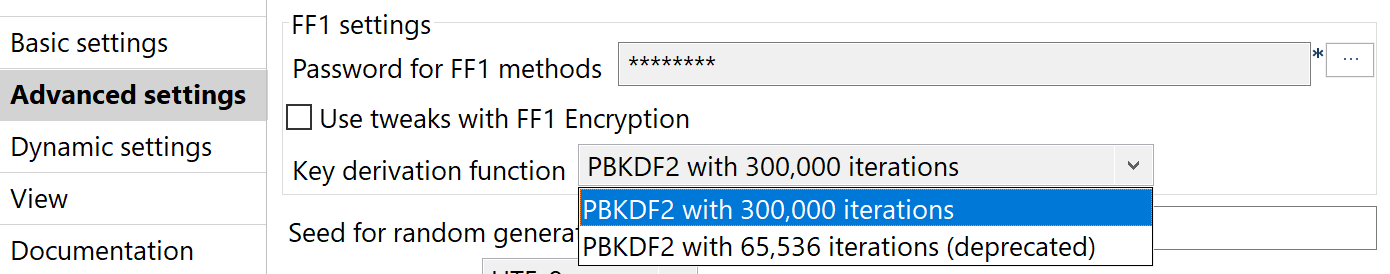

| Neue Funktion zur Schlüsselableitung | Die Datenschutzkomponenten wurden um die PBKDF2-Funktion zur Schlüsselableitung mit 300.000 Iterationen erweitert. Diese Funktion wird als Standard für neue Jobs verwendet. Aus Kompatibilitätsgründen mit Jobs vor 8.0 R2022-04 wird nach wie vor PBKDF2 mit 65.536 Iterationen unterstützt, ist jedoch veraltet. Wählen Sie die Funktion zur Schlüsselableitung in den Advanced settings (Erweiterte Einstellungen) aus.

Die neue Funktion ist verfügbar in:

|

Alle Produkte von Talend Platform und Data Fabric |

Anwendungsintegration: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

|

Die Standard-Endpunkte zur Microservice-Überwachung sind jetzt begrenzt auf Info, Gesundheit und Jolokia. |

Mit Studio Talend generierte Microservices bieten Zugriff auf Spring Boot Actuator-Endpunkte. Die Standard-Überwachungsendpunkte sind jetzt begrenzt auf Info, Gesundheit und Jolokia. |

Alle abonnementbasierte Produkte von Talend mit ESB |

Kontinuierliche Integration (CI = Continuous Integration): Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

| Talend CI Builder aktualisiert auf Version 8.0.4 | Talend CI Builder wurde von der Version 8.0.1 auf die Version 8.0.4 aktualisiert. Verwenden Sie ab dieser monatlichen Version Talend CI Builder 8.0.4 in Ihren CI-Befehlen (Continuous Integration: Kontinuierliche Integration) oder Pipeline-Skripten bis zur Veröffentlichung einer neuen Version von Talend CI Builder. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

| Neuer Befehl zur Installation von Talend CommandLine in einem eigenständigen CI-Schritt | Jetzt ist der neue Befehl mvn org.talend.ci:builder-maven-plugin:8.0.4:install verfügbar, der Ihnen die Installation von Talend CommandLine in einem eigenständigen CI-Schritt zur kontinuierlichen Integration ohne Erstellung eines Projekts oder Generierung von POM-Dateien ermöglicht. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

Hat diese Seite Ihnen geholfen?

Wenn Sie Probleme mit dieser Seite oder ihren Inhalten feststellen – einen Tippfehler, einen fehlenden Schritt oder einen technischen Fehler –, teilen Sie uns bitte mit, wie wir uns verbessern können!