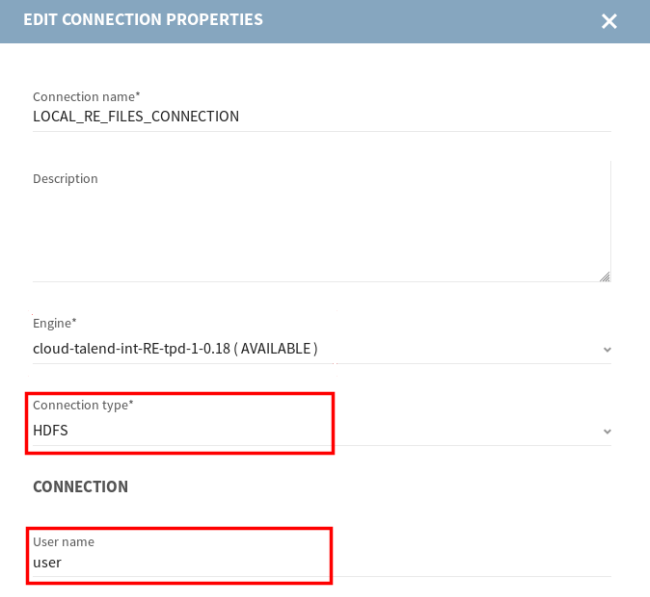

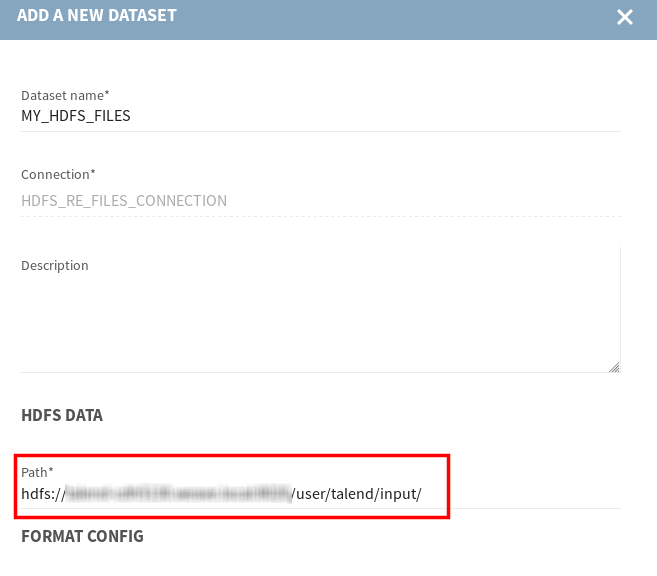

自分のエンジンからHadoopクラスター上のファイルにアクセス

始める前に

- ボリュームが正しくマウントされないという問題を回避できるよう、必ず最新バージョンのdocker-composeを使用してください。

- システム管理者に連絡し、Hadoop設定ファイル(core-site.xml、hdfs-site.xmlなど)の完全なリストセットを取得してください。

- これらのHadoop設定ファイルを自分のローカルマシンのフォルダーに保存し、そのパスをコピーしてください。

手順

このページは役に立ちましたか?

このページまたはコンテンツに、タイポ、ステップの省略、技術的エラーなどの問題が見つかった場合は、お知らせください。改善に役立たせていただきます。