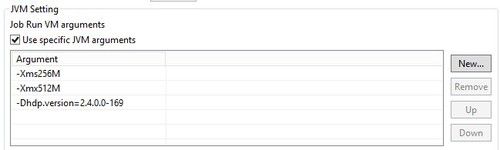

La valeur est spécifique à la distribution et à la version de Hadoop. Ce tutoriel utilise Hortonworks 2.4 V3, la version 2.4.0.0-169. Votre entrée pour ce paramètre sera différente si vous n'utilisez pas Hortonworks 2.4 V3.

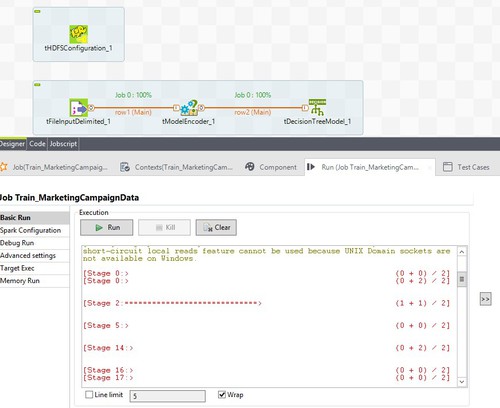

Note InformationsRemarque : Lorsque vous exécutez le code sur le cluster, il est crucial de vous assurer que l'accès est libre entre les deux systèmes. Dans cet exemple, vous devez vous assurer que le cluster Hortonworks peut communiquer avec votre instance du

Studio Talend. Cela est nécessaire car Spark, même s'il s'exécute sur le cluster, doit faire référence aux pilotes Spark fournis avec

Talend. De plus, si vous déployez un Job Spark dans un environnement de production, il sera exécuté depuis un serveur de Jobs

Talend (nœud de périphérie, edge node). Vous devez également vous assurer que la communication est libre entre lui et le cluster.

Pour plus d'informations concernant les ports nécessaires à chaque service, consultez la documentation Spark Security (en anglais).