Logs et points de contrôle des activités de votre Job Spark Apache

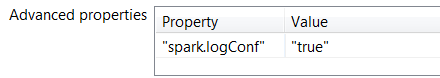

Il est recommandé d'activer le système de points de contrôle et de logs Spark dans l'onglet Spark configuration de la vue Run de votre Job Spark pour faciliter le débogage et reprendre votre Job Spark lorsque vous êtes confronté à des problèmes.

Les informations contenues dans cette section concernent uniquement les utilisateurs et utilisatrices ayant souscrit à Talend Data Fabric ou à un produit Talend avec Big Data.

Procédure

Cette page vous a-t-elle aidé ?

Si vous rencontrez des problèmes sur cette page ou dans son contenu – une faute de frappe, une étape manquante ou une erreur technique – dites-nous comment nous améliorer !