HBaseへの接続の作成

手順

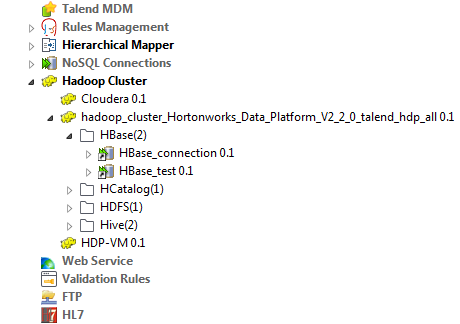

タスクの結果

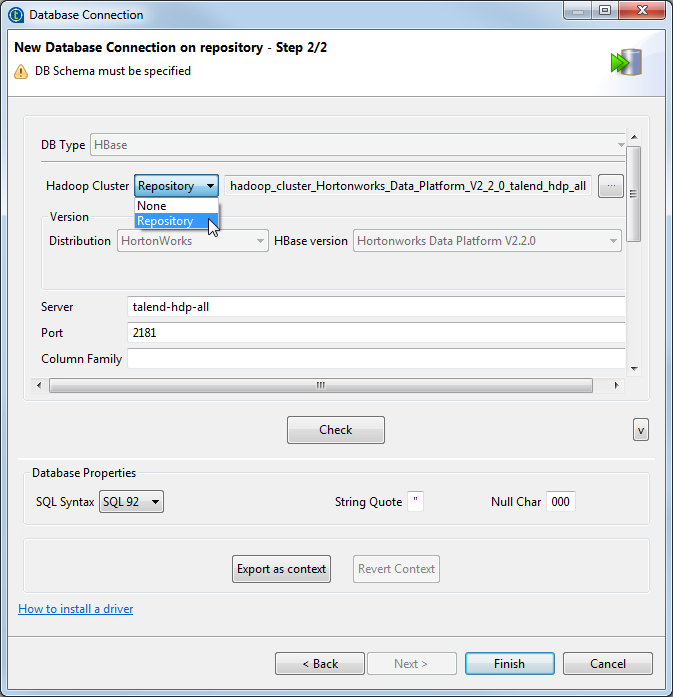

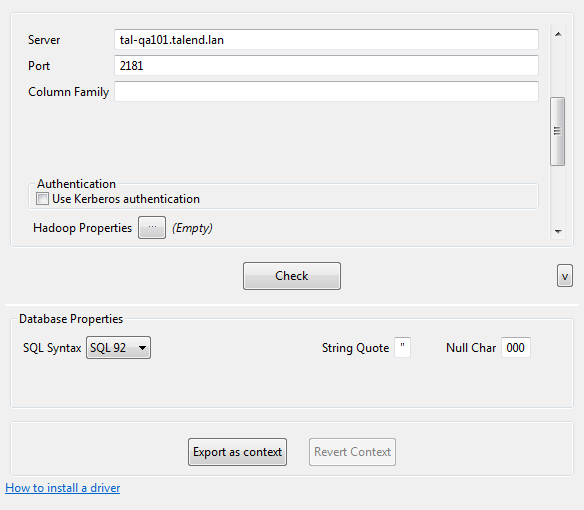

環境コンテキストを使用してこの接続のパラメーターを定義する必要がある場合は、[Export as context] (コンテキストとしてエクスポート)ボタンをクリックして対応するウィザードを開き、以下のオプションから選択します。

-

[Create a new repository context] (新しいリポジトリーコンテキストを作成): 現在のHadoop接続からこの環境コンテキストを作成します。つまり、ウィザードで設定するパラメーターは、これらのパラメーターに設定した値と共にコンテキスト変数として取られます。

-

[Reuse an existing repository context] (既存のリポジトリーコンテキストを再利用): 特定の環境コンテキストの変数を使用して現在の接続を設定します。

[Export as context] (コンテキストとしてエクスポート)機能の使用方法の詳細な例は、メタデータのコンテキストとしてエクスポート、およびコンテキストパラメーターを再利用して接続を設定をご覧ください。

このページは役に立ちましたか?

このページまたはコンテンツに、タイポ、ステップの省略、技術的エラーなどの問題が見つかった場合は、お知らせください。改善に役立たせていただきます。