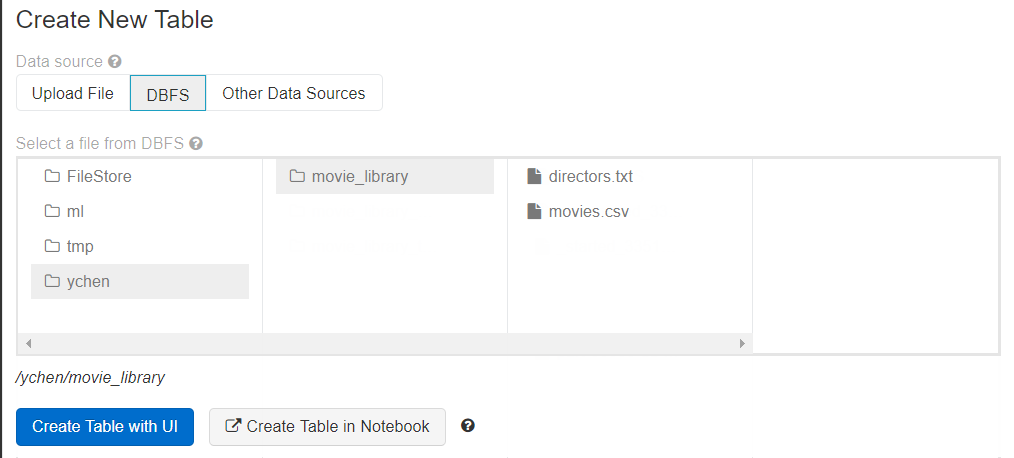

DBFS (Databricks File System)にファイルをアップロード

ファイルをDBFSにアップロードすると、ビッグデータジョブによる読み取りと処理が可能になります。DBFSは、この例で使用されるビッグデータファイルシステムです。

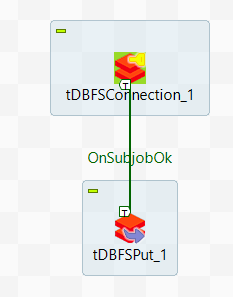

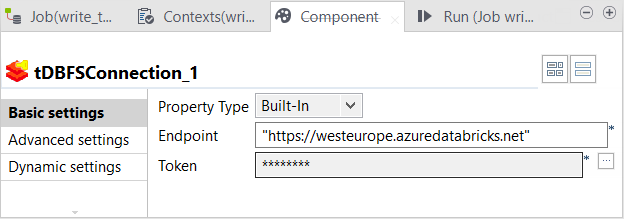

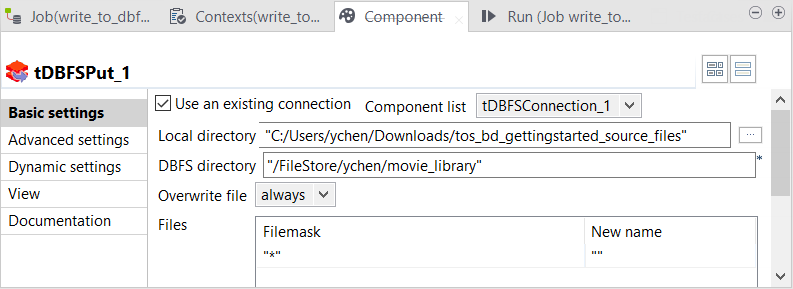

この手順では、DBFSシステムにデータを書き込むジョブを作成します。ユースケースに必要なファイルについては、このページの左パネルにある[Downloads] (ダウンロード)タブからtdf_gettingstarted_source_files.zipをダウンロードします。

始める前に

-

Talend Studioを起動し、 Integration パースペクティブを開いていること。

手順

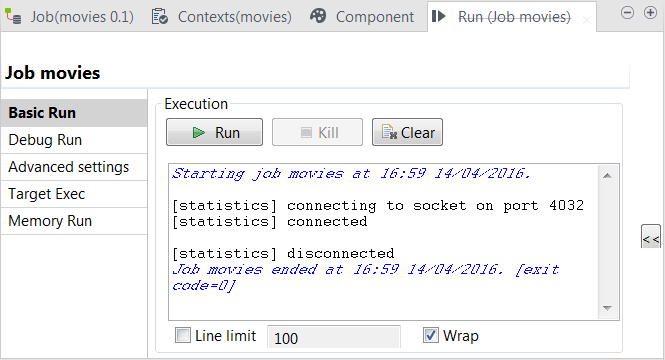

タスクの結果

ジョブが完了すると、アップロードしたファイルはDBFS内の指定したディレクトリーにあります。

このページは役に立ちましたか?

このページまたはコンテンツに、タイポ、ステップの省略、技術的エラーなどの問題が見つかった場合は、お知らせください。改善に役立たせていただきます。