データをKafkaトピックに送信

このシナリオは、パイプラインでコネクターを簡単にセットアップして使用できるようにすることを目的としています。お使いの環境とユースケースに適応させてください。

始める前に

- このシナリオを再現する場合は、test-file-to-kafka.zipファイルをダウンロードして抽出します。

手順

タスクの結果

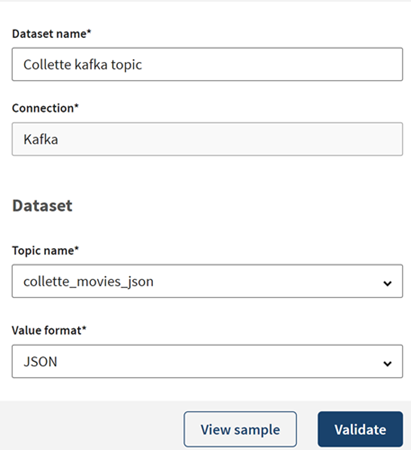

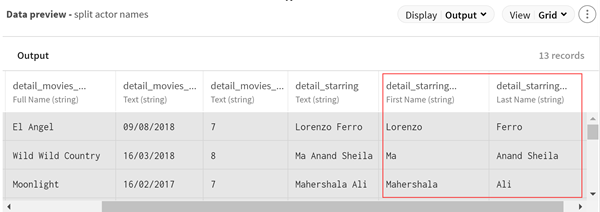

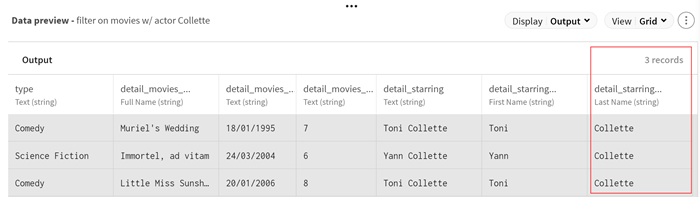

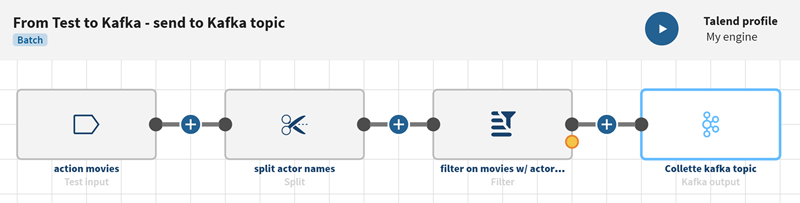

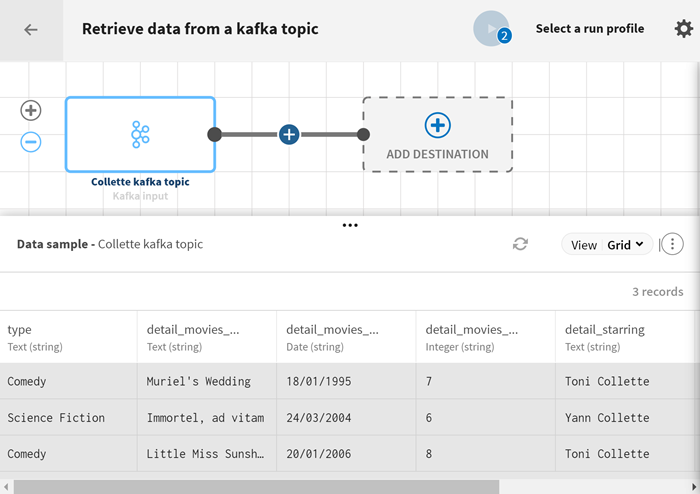

パイプラインは実行中となり、テストファイルからの映画データが処理され、定義したcollette_movies_json トピックに出力フローが送信されます。

次のタスク

イベントが公開された後は、別のパイプラインでトピックのコンテンツを消費してソースとして使用できます。

このページは役に立ちましたか?

このページまたはコンテンツに、タイポ、ステップの省略、技術的エラーなどの問題が見つかった場合は、お知らせください。改善に役立たせていただきます。