Neuheiten in R2022-09

Big Data: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

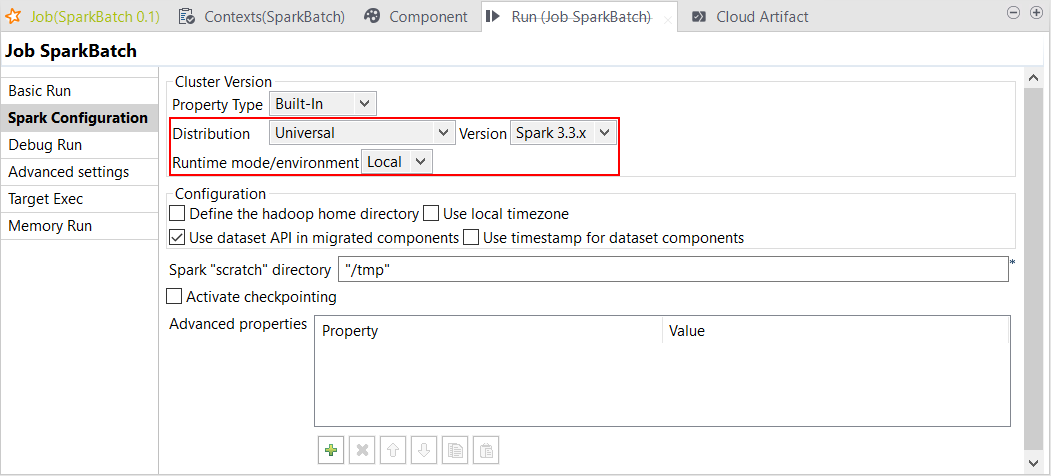

| Unterstützung für Spark Universal 3.3.x im lokalen Modus | Sie können Ihre Spark Batch- und Streaming-Jobs jetzt unter Rückgriff auf Spark Universal mit Spark 3.3.x im lokalen Modus (Local) ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Die Big Data-Komponenten von Talend Data Mapper und Talend Data Quality waren zum Zeitpunkt dieser Release nicht mit Spark 3.3.x kompatibel. Aus diesem Grund bleibt Spark Universal 3.2.x die Standardversion für diesen Patch. Spark 3.3.x wird ab Version R2020-10 unterstützt.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

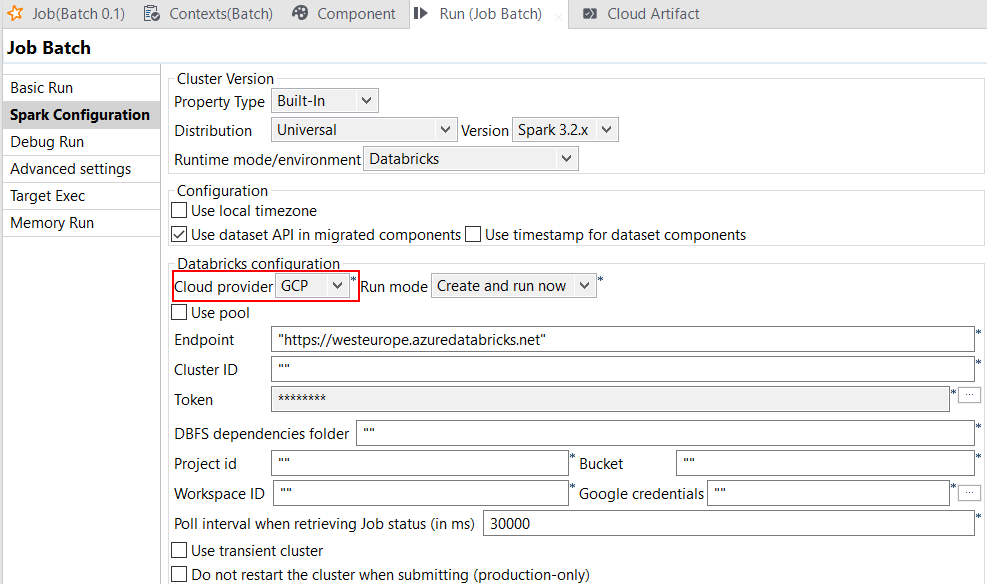

| Unterstützung für Databricks Runtime ab 10.x mit GCP unter Spark Universal 3.2.x | Sie können Ihre Spark Batch- und Streaming-Jobs jetzt in jobbasierten wie auch in multifunktionalen Databricks-Clustern in Google Cloud Platform (GCP) unter Rückgriff auf Spark Universal mit Spark 3.2.x ausführen. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Wenn Sie diesen Modus auswählen, ist Studio Talend mit Databricks ab Version 10.x kompatibel.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

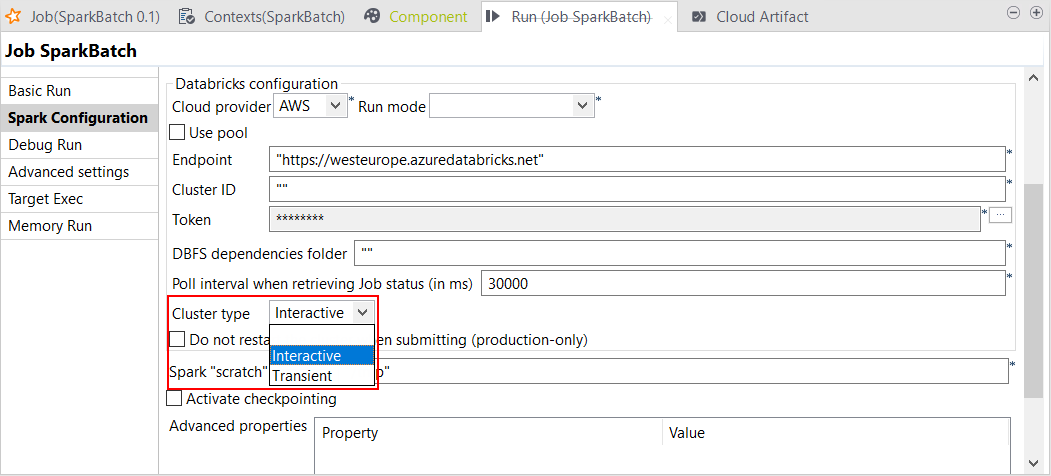

| Unterstützung für Kontextgruppen zur Umschaltung von jobbasierten zu multifunktionalen Clustern in Databricks für Spark-Jobs | Sie können jetzt in Databricks mithilfe von Kontextgruppen von jobbasierten zu multifunktionalen Clustern umschalten. Bei der Konfiguration der Verbindung zum Databricks-Cluster können Sie jetzt spezifische Kontextgruppen hinzufügen, die bei der Ausführung Ihrer Spark-Jobs verwendet werden. Die Konfiguration erfolgt entweder in der Ansicht Spark Configuration (Spark-Konfiguration) Ihrer Spark-Jobs oder im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung). Es wird jedoch empfohlen, die Konfiguration im Metadaten-Assistenten Hadoop Cluster Connection (Hadoop-Clusterverbindung) vorzunehmen.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

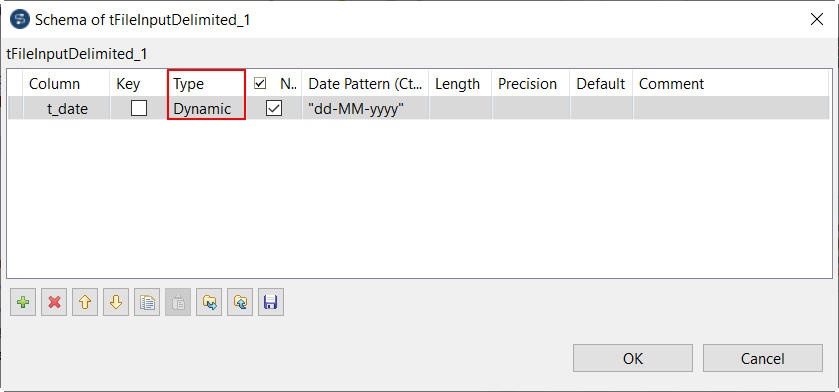

| Erweiterung von tFileInputDelimited zur Unterstützung eines dynamischen Schemas in Spark Batch-Jobs | Sie können jetzt im Schema von tFileInputDelimited in Ihren Spark Batch-Jobs eine dynamische Spalte hinzufügen. Mit der dynamischen Schemafunktion können Sie ein Schema auf nicht-statische Weise konfigurieren, d. h. Sie müssen Ihren Spark-Job bei einer künftigen Schema-Änderung nicht umgestalten und stellen dabei sicher, dass er stets ordnungsgemäß funktioniert.

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

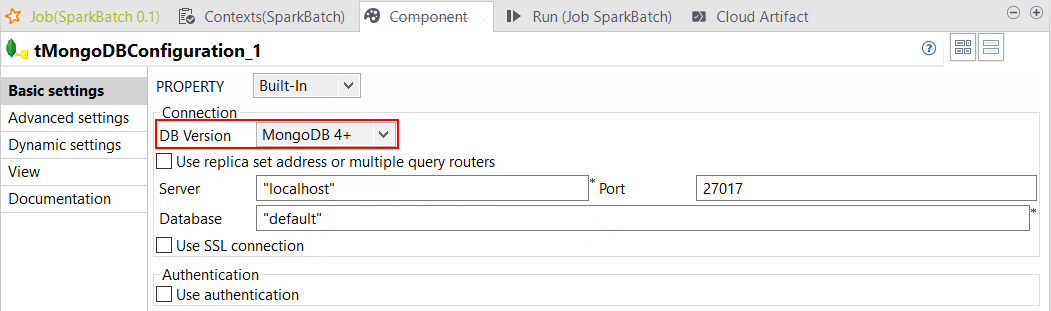

| Unterstützung für MongoDB v4+ für Spark Batch ab Version 3.1 | Studio Talend bietet jetzt Unterstützung für MongoDB v4+ mit Spark ab Version 3.1 für die folgenden Komponenten in Ihren Spark Batch-Jobs unter Verwendung von Dataset:

|

Alle abonnementbasierte Produkte von Talend mit Big Data |

Data Integration: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

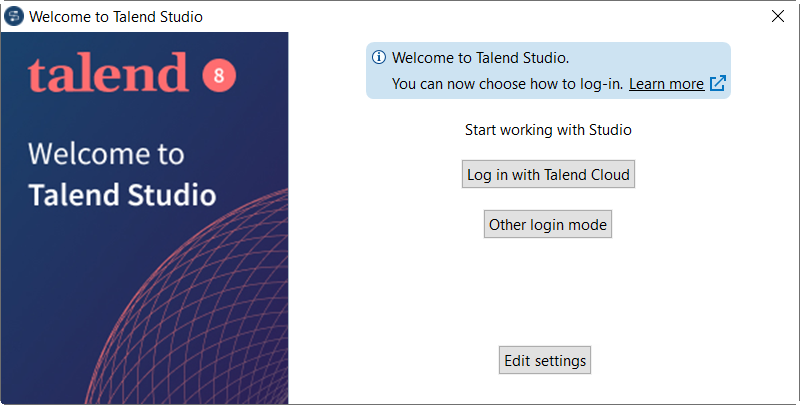

| SSO-Anmeldung bei Studio Talend über Talend Cloud | Wenn Sie mit Talend Cloud arbeiten, können Sie sich jetzt über Talend Cloud bei Studio Talend anmelden, entweder unter Rückgriff auf SSO oder auf die herkömmliche Weise. Im Anmeldefenster stehen folgende zwei Optionen zur Verfügung:

InformationshinweisAnmerkung: Die Anmeldung bei Studio Talend über Talend Cloud wird zurzeit nicht für Linux auf ARM64 unterstützt.

Weitere Informationen finden Sie unter „Starten von Talend Studio“.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

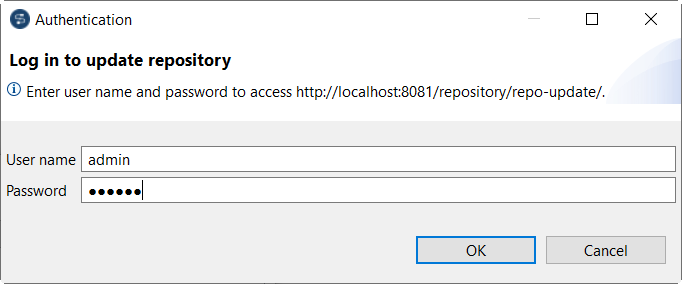

| Unterstützung der Basisauthentifizierung für den Zugriff auf Update-Repositories | Studio Talend unterstützt jetzt die Basisauthentifizierung für Update-Repositories unter Rückgriff auf den sicheren Eclipse-Speicher. Weitere Informationen finden Sie unter „Basisauthentifizierung für Update-Repositories in Talend Studio“.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

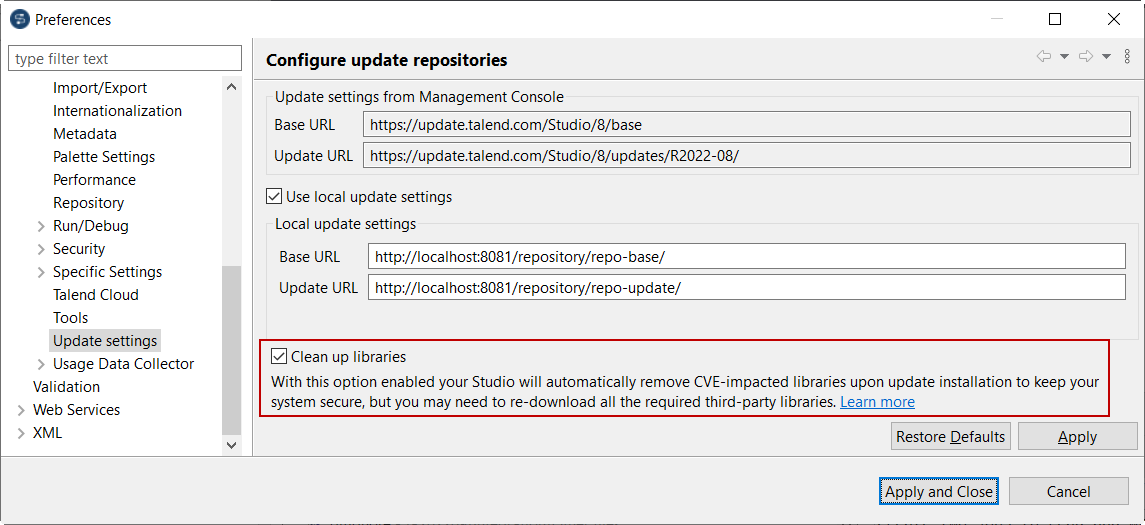

| Neue Option zur Bereinigung veralteter Bibliotheken bei der Update-Installation | Sie können Studio Talend für die automatische Bereinigung veralteter Bibliotheken bei der Installation von Updates konfigurieren. Führen Sie dazu einen der folgenden Schritte durch:

Dadurch wird Speicherplatz gespart und die von den Sicherheitstools bei der Suche nach Schwachstellen in Bibliotheken erzeugten Störungen werden reduziert. Beachten Sie Folgendes:

Weitere Informationen finden Sie unter „Aktualisieren von Talend Studio“.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

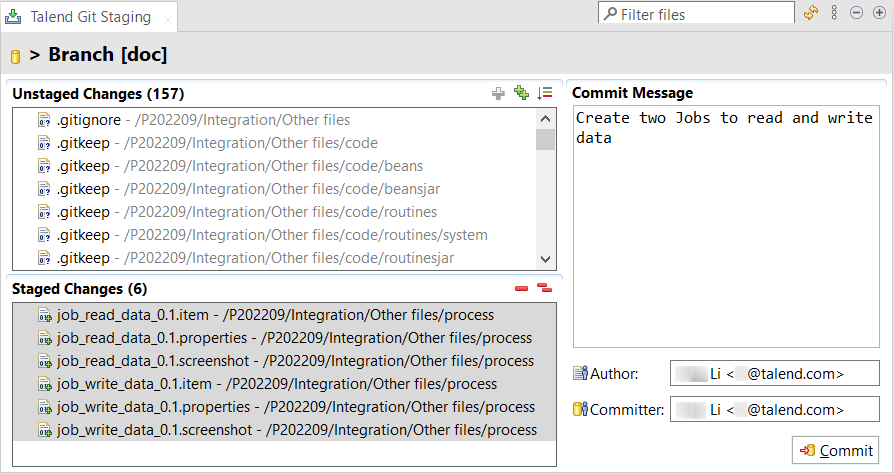

| E-Mail bei der Arbeit mit Talend Cloud als Git-Commit-Autor verwendet | Wenn Sie an einem von Talend Management Console verwalteten Projekt arbeiten, wird anstelle des Anmeldenamens in Talend Management Console die E-Mail als Git-Autor und Committer bei der Übergabe Ihrer Änderungen an Git in Studio Talend verwendet.

|

Alle Produkte von Talend Cloud und Talend Data Fabric |

| Neue Komponenten für die Verbindung zu Google Bigtable zum Speichern/Abrufen von Daten | Studio Talend unterstützt jetzt die folgenden neuen Komponenten für den Aufbau einer Verbindung zu Google Bigtable, um Daten zu speichern bzw. abzurufen:

|

Alle Produkte von Talend Platform und Data Fabric |

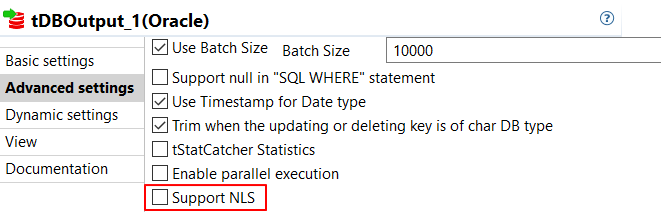

| Neue Option in Oracle-Komponenten und Metadaten-Assistent zum Hinzufügen einer Globalisierungsunterstützung | Oracle-Komponenten wie auch der Metadaten-Assistent stellen die Option Support NLS (NLS-Unterstützung) bereit, über die Globalisierungsunterstützung für Oracle ab Version 18 aktiviert werden kann.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

| Neue Komponente zum Schreiben an Workday-Clients | Diese Release umfasst die tWorkdayOutput-Komponente, die Ihnen das Schreiben von Daten an einen Workday-Client ermöglicht. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

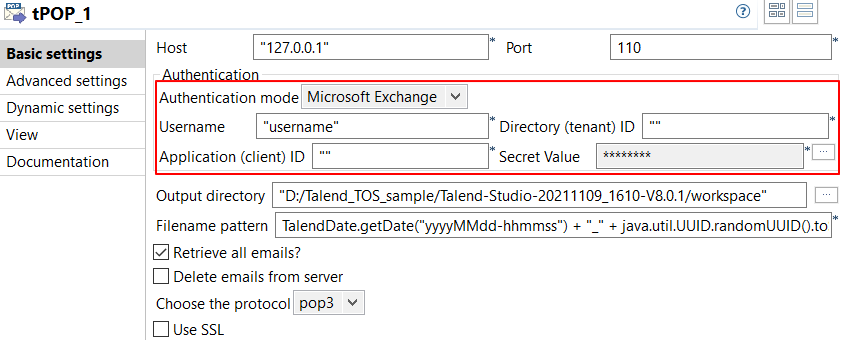

| Unterstützung der Microsoft Exchange-Authentifizierung in tPOP | Die tPOP-Komponente stellt den Microsoft Exchange-Authentifizierungsmodus zur Verfügung, sodass Sie Nachrichten im Microsoft Exchange-Authentifizierungsmodus abrufen können.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

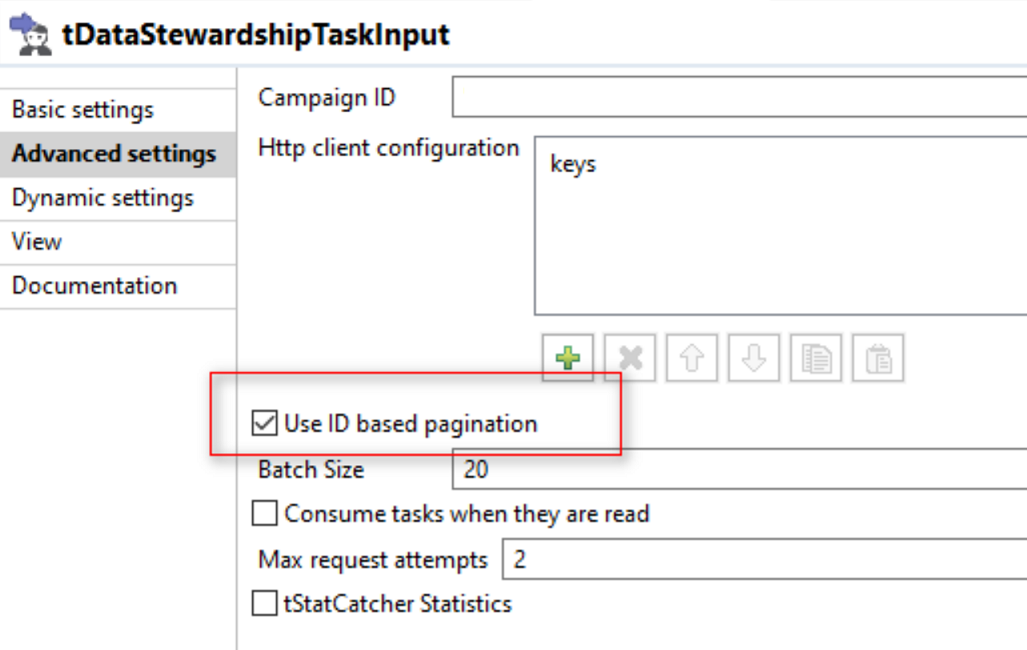

| ID-basierte Paginierung für die Komponente tDataStewardshipTaskInput | Aktivieren Sie diese Option, um die Leistung beim Abrufen und Sortieren der Tasks von Talend Cloud Data Stewardship zu verbessern.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

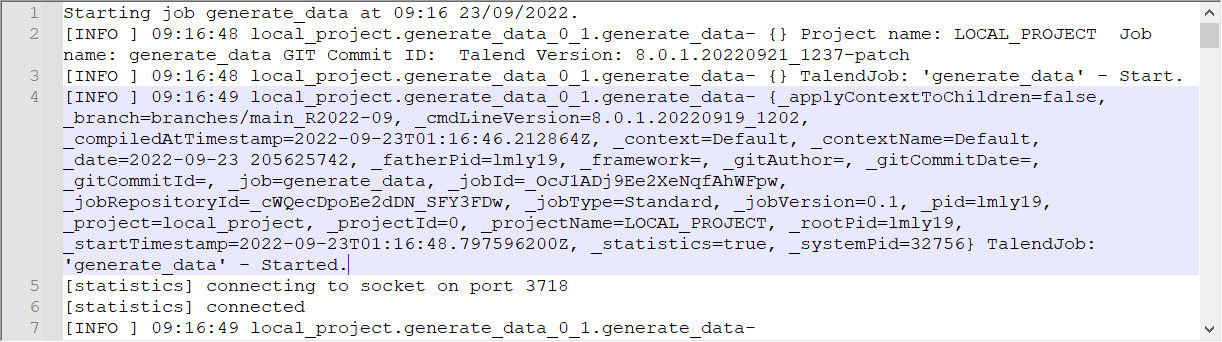

| Zusätzliche Log-Attribute über MDC bei Verwendung von Log4j 2 | Wenn Sie Apache Log4j 2 in Ihren Jobs verwenden, wird der Log4j 2-MDC (Mapped Diagnostic Context) jetzt mit Schlüssel-/Wert-Paaren gefüllt. Diese zusätzlichen Log-Attribute vereinfachen die Identifizierung des Threads, in dem Logdaten generiert werden, wenn alle Log-Meldungen von verschiedenen Threads in eine einzelne Datei geschrieben werden. Weitere Informationen zum Log4j 2-MDC finden Sie unter Log4j 2-API - Thread-Kontext. Um die zusätzlichen Log-Attribute beim Schreiben von Logs einzubeziehen, müssen Sie die Log4j 2-Vorlage in Studio Talend entsprechend konfigurieren. Weitere Informationen finden Sie unter „Aktivieren und Konfigurieren von Log4j“.

|

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

Data Mapper: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

|

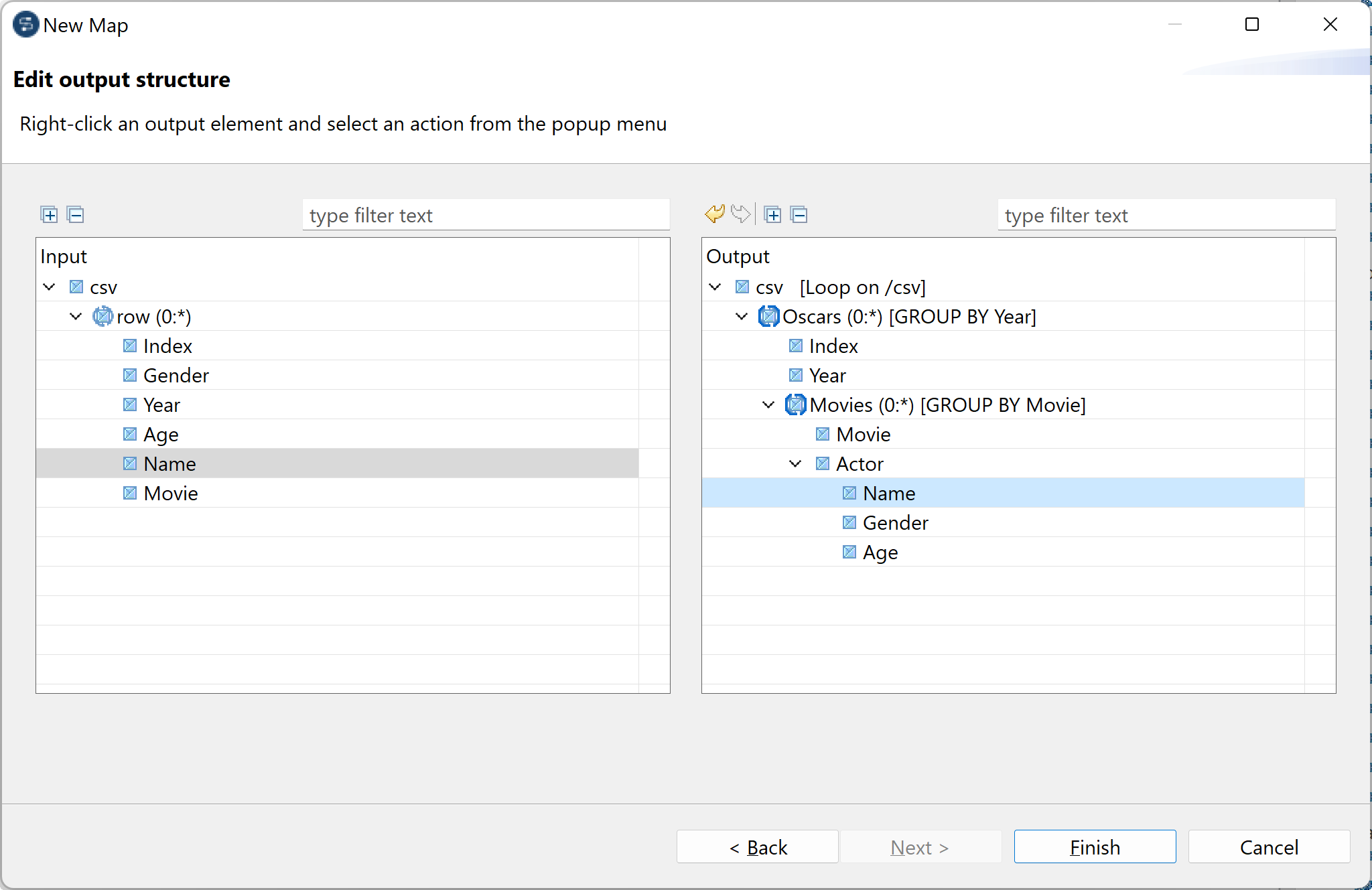

Von flacher zu hierarchischer Map |

Ein neuer Map-Typ ermöglicht Ihnen die Erstellung einer hierarchischen Struktur ausgehend von einer flachen Struktur sowie das entsprechende Mapping. Sie können die Ausgabestruktur bearbeiten, Arrays und Datensätze erstellen und die Daten auf der Grundlage eines spezifischen Elements gruppieren. Nach der Definition der Ausgabestruktur wird eine Map erstellt und die Eingabe automatisch der Ausgabe zugeordnet (Mapping).

|

Alle Produkte von Talend Platform und Data Fabric |

Data Quality: Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

| Unterstützung von Spark 3.2 im lokalen Modus und in Databricks | Die DQ-Komponenten können jetzt unter Rückgriff auf Apache Spark 3.2 im lokalen Modus und in Databricks ausgeführt werden. Hierbei gelten einige Ausnahmen:

|

Alle Produkte von Talend Platform und Data Fabric |

Kontinuierliche Integration (CI = Continuous Integration): Neue Funktionen

|

Funktion |

Beschreibung |

Verfügbar in |

|---|---|---|

| Talend CI Builder aktualisiert auf Version 8.0.9 | Talend CI Builder wurde von der Version 8.0.8 auf die Version 8.0.9 aktualisiert. Verwenden Sie ab dieser monatlichen Version Talend CI Builder 8.0.9 in Ihren CI-Befehlen (Continuous Integration: Kontinuierliche Integration) oder Pipeline-Skripten bis zur Veröffentlichung einer neuen Version von Talend CI Builder. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

| Unterstützung der Basisauthentifizierung für Update-Repositories | Wenn die Basisauthentifizierung in Studio Talend aktiviert wird, können Sie jetzt folgende Parameter in Ihren CI-Befehlen verwenden, um sicher auf die Update-Repositories von Talend zugreifen zu können:

Weitere Informationen finden Sie unter „Basisauthentifizierung für Update-Repositories in Talend Studio“und „CI Builder-bezogene Maven-Parameter“. |

Alle abonnementbasierte Produkte von Talend mit Studio Talend |

Hat diese Seite Ihnen geholfen?

Wenn Sie Probleme mit dieser Seite oder ihren Inhalten feststellen – einen Tippfehler, einen fehlenden Schritt oder einen technischen Fehler –, teilen Sie uns bitte mit, wie wir uns verbessern können!