Utiliser le filtre sur les propriétés Hadoop du Studio pour résoudre le problème de moteur Tez avec Hive pour les Jobs Spark dans une distribution Hortonworks

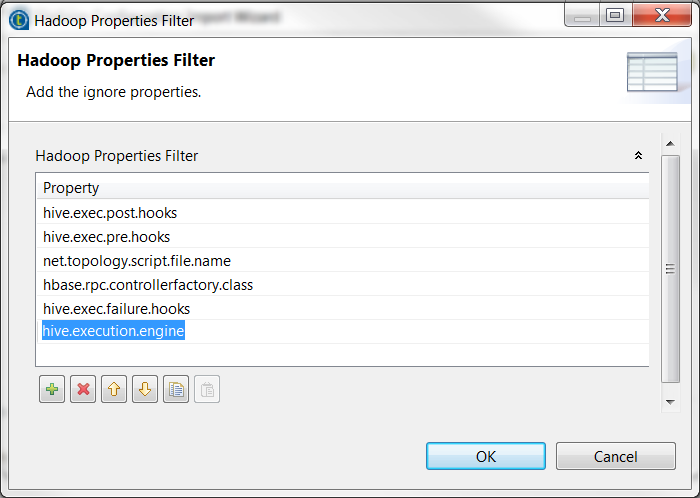

Si vous devez utiliser le fichier original hive-site.xml de votre cluster Hortonworks ou si vous n'avez pas accès aux fichiers de configuration spécifiques à Spark, vous pouvez utiliser le filtre des propriétés fourni dans l'assistant de métadonnées Hadoop dans le Studio pour régler ce problème.