Configuration d'un Job Big Data Streaming utilisant le framework Spark Streaming

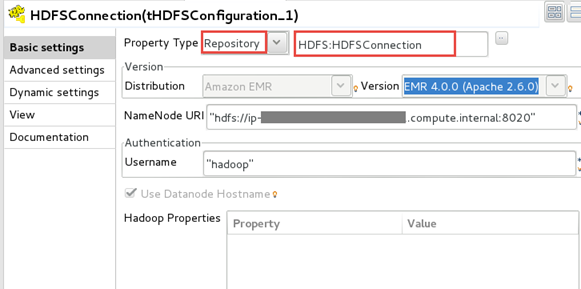

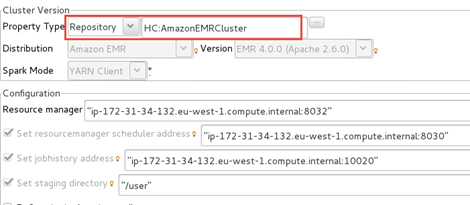

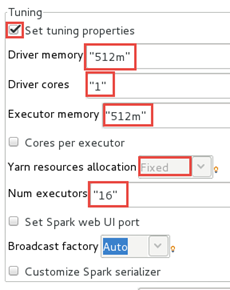

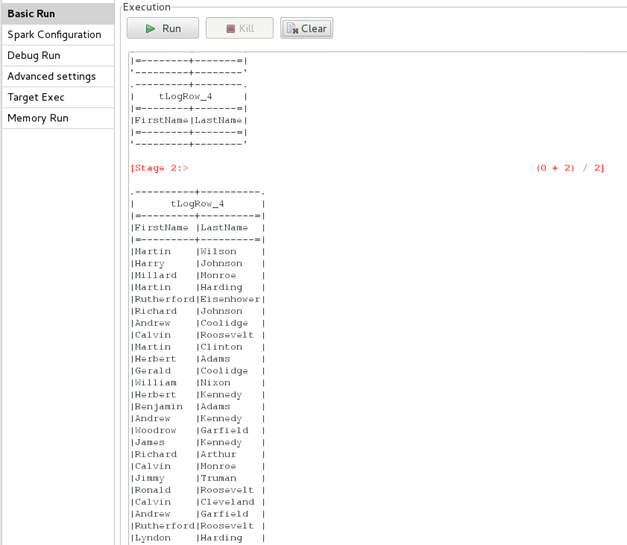

Avant d'exécuter votre Job, vous devez le configurer pour utiliser votre cluster Amazon EMR.

Procédure

Cette page vous a-t-elle aidé ?

Si vous rencontrez des problèmes sur cette page ou dans son contenu – une faute de frappe, une étape manquante ou une erreur technique – dites-nous comment nous améliorer !