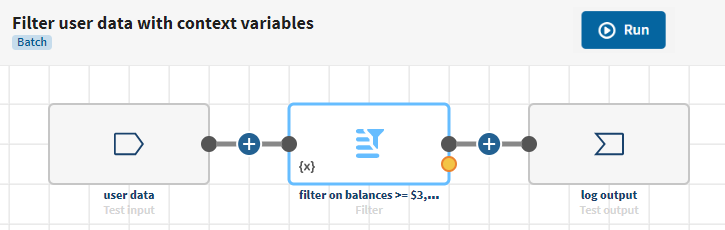

Utiliser des variables de contexte pour filtrer différentes données lors de l'exécution

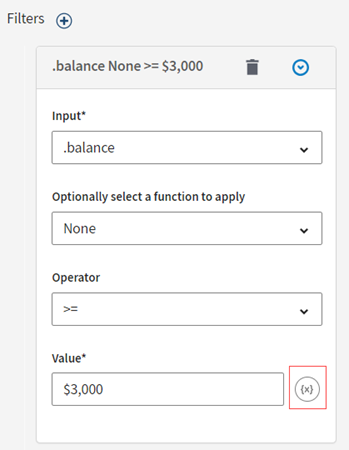

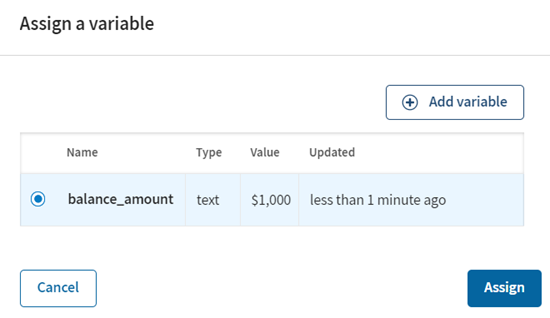

Dans ce scénario, une variable de contexte est ajoutée pour écraser la valeur utilisée pour filtrer les données utilisateur·trices lors de l'exécution.

Avant de commencer

-

Vous avez précédemment créé une connexion au système stockant vos données source, ici une connexion Test.

-

Vous avez précédemment ajouté le jeu de données contenant vos données source.

Des données relatives à des nombre d'utilisateurs et d'utilisatrices connecté·e·s, notamment des noms, entreprises, adresses e-mail, soldes de comptes etc. Pour plus d'informations, consultez Créer un jeu de données de test.

- Vous avez également créé le jeu de données de test de destination pour stocker la sortie des logs.

Procédure

Résultats

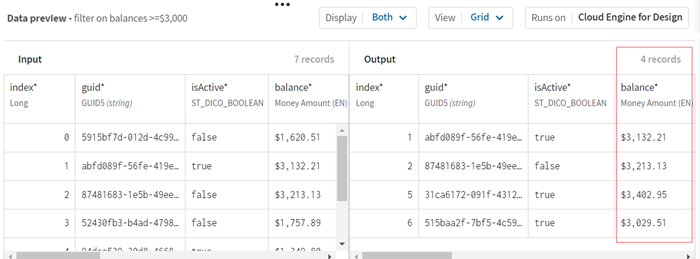

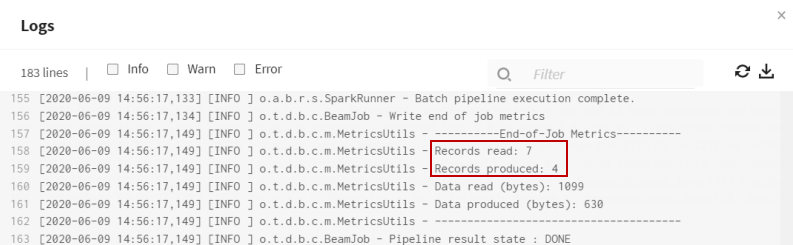

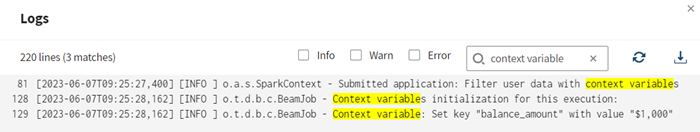

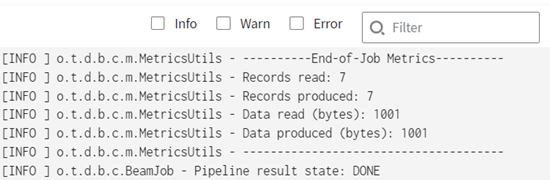

Votre pipeline est en cours d'exécution, les données sont filtrées selon la variable de contexte attribuée à la valeur de filtre. Dans les logs d'exécution du pipeline, vous pouvez voir :

- la valeur de variable de contexte utilisée lors de l'exécution

- le nombre d'enregistrements produits, ici 7 enregistrements répondent aux critères, ce qui signifie que 7 enregistrements utilisateur ont un solde de compte supérieur ou égal à mille dollars

Cette page vous a-t-elle aidé ?

Si vous rencontrez des problèmes sur cette page ou dans son contenu – une faute de frappe, une étape manquante ou une erreur technique – dites-nous comment nous améliorer !