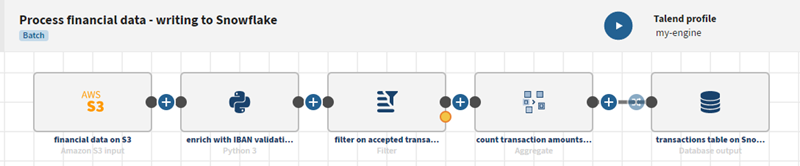

Schreiben von Daten in ein cloudbasiertes Data Warehouse (Snowflake)

Vorbereitungen

-

Sie haben die Datei financial_transactions.avro heruntergeladen und sie in Ihr Amazon S3-Bucket hochgeladen.

- Sie haben die unter Schreiben von Daten in einen Cloud-Speicher (S3) beschriebene Pipeline reproduziert und dupliziert und arbeiten jetzt mit dieser duplizierten Pipeline.

- Sie haben eine Moteur distant Gen2 sowie das zugehörige Ausführungsprofil über Talend Management Console erstellt.

In Talend Management Console sind standardmäßig die Moteur Cloud pour le design und ein entsprechendes Ausführungsprofil integriert. Dadurch können die Benutzer in kürzester Zeit ihre Arbeit mit der Anwendung aufnehmen. Es wird jedoch empfohlen, die sichere Moteur distant Gen2 zu installieren, die eine erweiterte Datenverarbeitung ermöglicht.

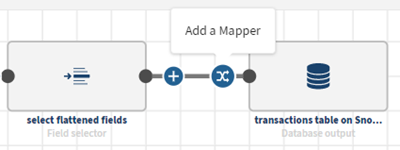

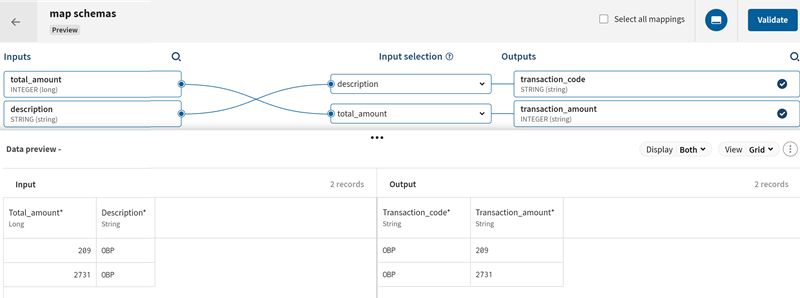

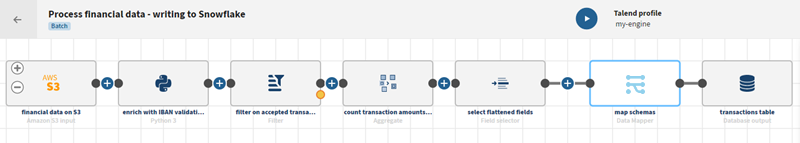

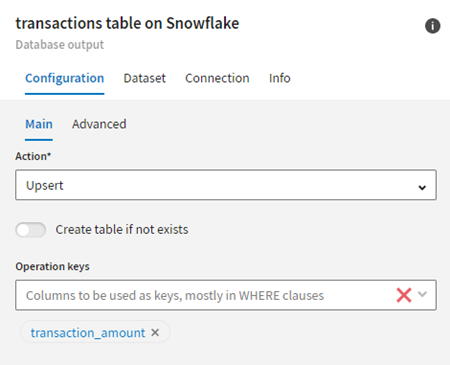

Prozedur

Ergebnisse

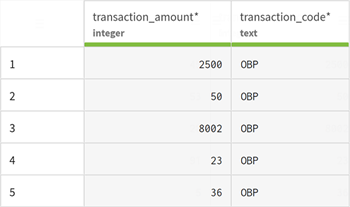

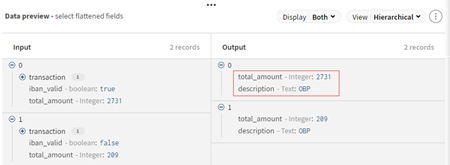

Sobald die Pipeline ausgeführt wird, werden die aktualisierten Daten in der Snowflake-Datenbanktabelle angezeigt.

Hat diese Seite Ihnen geholfen?

Wenn Sie Probleme mit dieser Seite oder ihren Inhalten feststellen – einen Tippfehler, einen fehlenden Schritt oder einen technischen Fehler –, teilen Sie uns bitte mit, wie wir uns verbessern können!